Summary

View original tweet →Đánh Giá Ứng Dụng LLM với DeepEval: Hướng Dẫn Toàn Tập

Trong thế giới AI đang phát triển như vũ bão, đặc biệt là với sự bùng nổ của các Mô Hình Ngôn Ngữ Lớn (LLMs), việc có một công cụ đánh giá xịn sò là điều không thể thiếu. Mới đây, trên Twitter, anh @svpino đã chia sẻ về DeepEval - một thư viện mã nguồn mở siêu tiện lợi để đánh giá các ứng dụng chạy bằng LLM. Bài viết này sẽ "đào sâu" hơn những gì anh ấy chia sẻ, giúp bạn hiểu rõ hơn về DeepEval và cách nó có thể tích hợp vào quy trình phát triển của bạn.

DeepEval là gì mà hot thế?

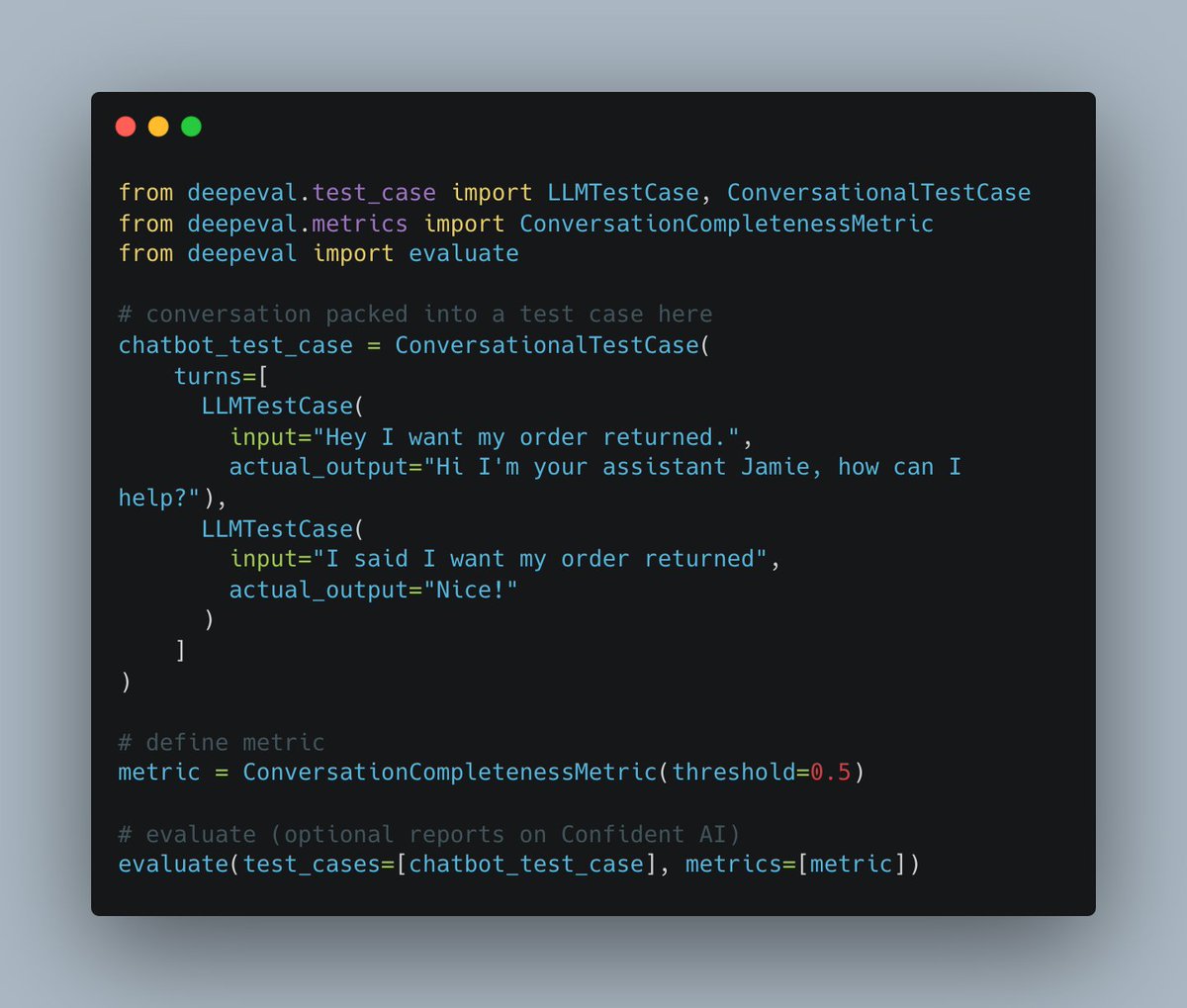

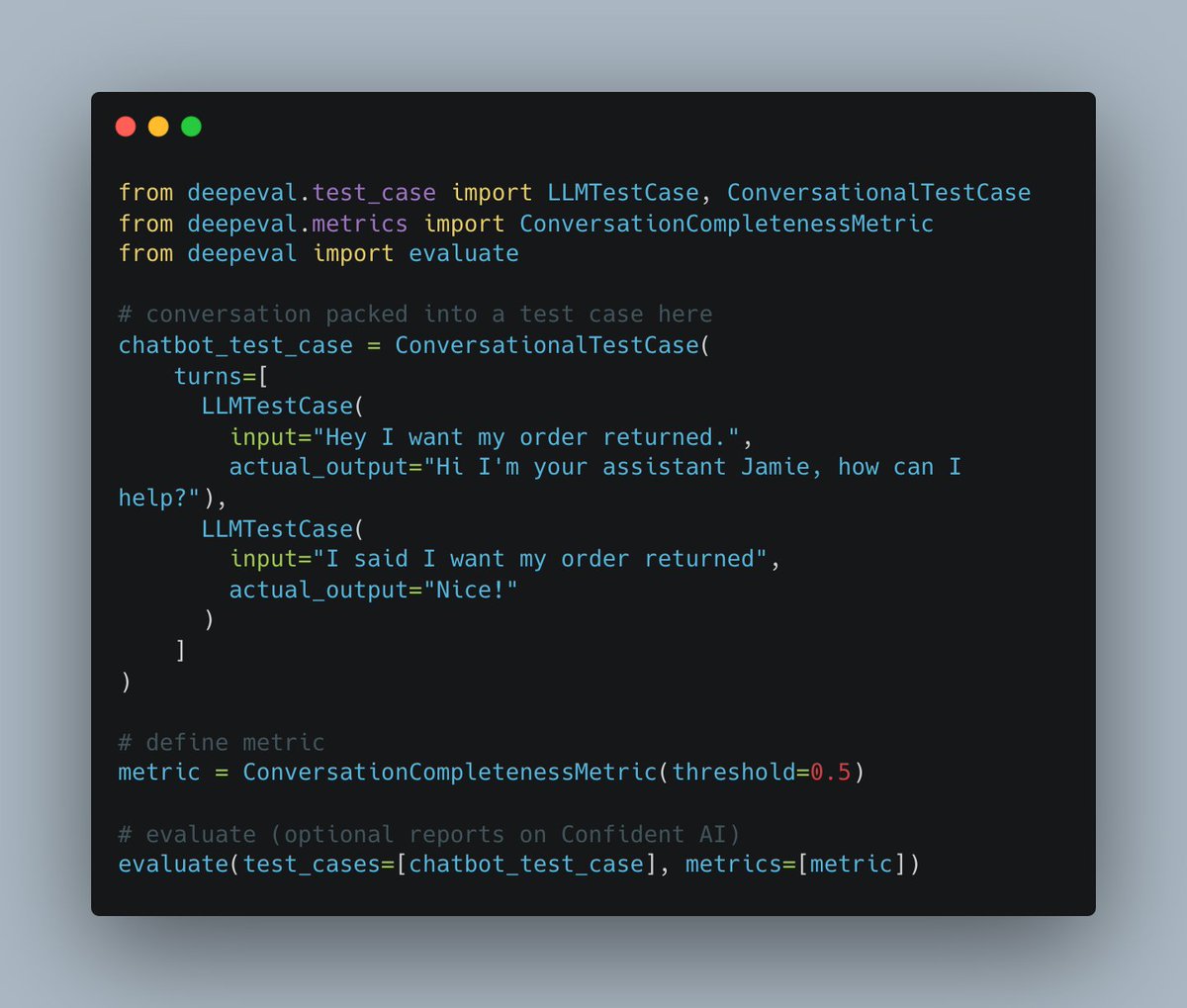

Ngay từ tweet đầu tiên, anh @svpino đã nhấn mạnh tầm quan trọng của việc test các ứng dụng LLM để đảm bảo chúng hoạt động đúng như ý muốn. DeepEval có thể được dùng để đánh giá nhiều loại ứng dụng khác nhau, từ chatbot đến các hệ thống RAG (retrieval-augmented generation). Nhưng mà, đời không như là mơ, LLM cũng có thể gặp mấy "phốt" như bịa chuyện (hallucination) hay bị người dùng "bẻ khóa" (jailbreak). Để minh họa, anh ấy còn share một đoạn code mẫu, chỉ cách dùng DeepEval để kiểm tra độ "trọn vẹn" của một cuộc trò chuyện chatbot. Xem mà mê luôn!

Linh hoạt như ninja, DeepEval cân hết!

Điểm đáng chú ý của DeepEval là nó hỗ trợ đánh giá bất kỳ LLM nào, kể cả mấy framework nổi tiếng như Langchain hay Transformers của Hugging Face. Nhưng mà, cũng phải lưu ý là nếu bạn xài mấy model "cây nhà lá vườn" mà thiếu khả năng suy luận thì kết quả đánh giá có thể không được chuẩn lắm đâu nha. Dù vậy, sự linh hoạt này giúp bạn tùy chỉnh việc đánh giá theo nhu cầu riêng, biến DeepEval thành một công cụ "đa-zi-năng" trong kho đồ nghề AI.

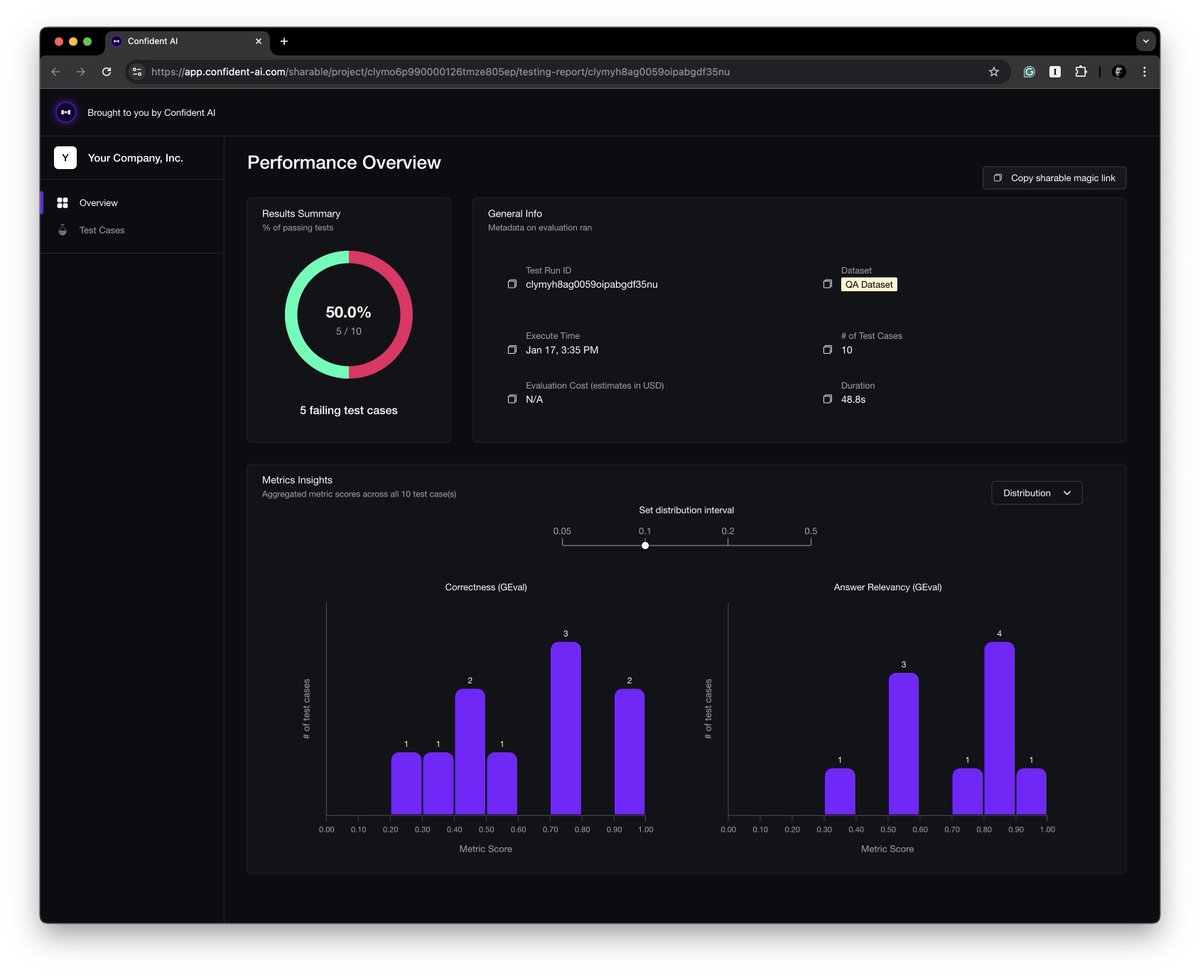

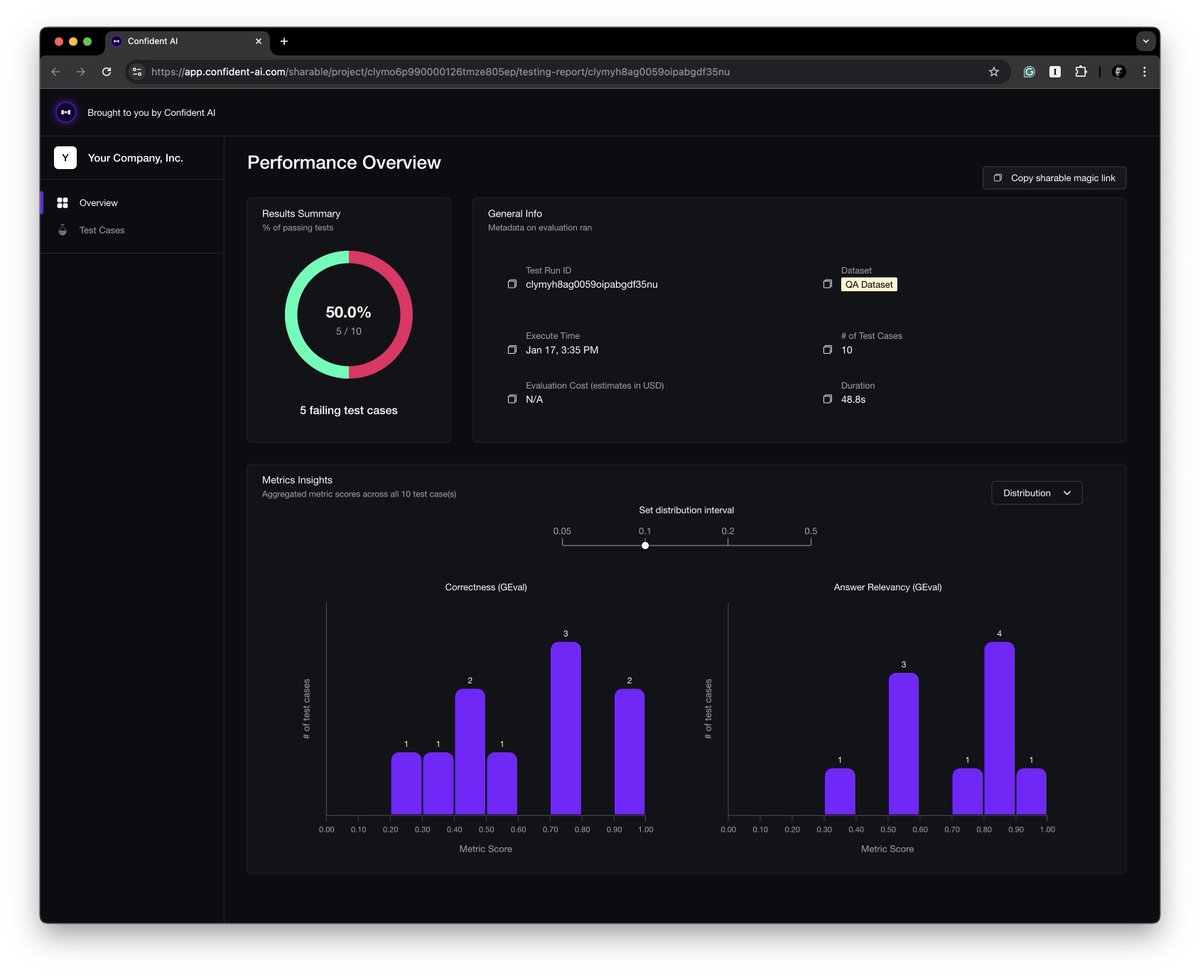

Dễ xài như ăn kẹo

Tweet thứ hai của anh @svpino là một hướng dẫn từng bước để bắt đầu với DeepEval. Anh ấy khuyến khích mọi người cài thư viện, tạo các test case cho LLM, và chọn mấy chỉ số (metrics) phù hợp để test. Ngoài ra, anh còn giới thiệu nền tảng Confident AI, giúp DeepEval mạnh mẽ hơn với một dashboard xịn sò để benchmark ứng dụng và theo dõi hiệu suất.

Tích hợp Pytest: "Chơi lớn" luôn!

Một điểm cộng to đùng của DeepEval là nó tích hợp được với Pytest. Điều này cho phép bạn chạy các bài đánh giá như mấy bài test unit thông thường, dễ dàng nhét vào quy trình CI/CD hiện tại. Nói nôm na là bạn có thể phát hiện lỗi hay tụt hiệu suất ngay từ sớm, khỏi phải "chữa cháy" về sau.

Đo lường chất lượng hội thoại: Không chỉ là "chém gió"

DeepEval còn cung cấp một loạt các chỉ số để đánh giá chất lượng hội thoại của chatbot. Những chỉ số này xem xét cả lịch sử hội thoại, giúp bạn đánh giá các yếu tố như khả năng "nhớ bài" hay độ liên quan của câu trả lời. Tập trung vào mấy cái này là chìa khóa để tạo ra mấy con chatbot vừa "mặn" vừa "chất".

Tài liệu hướng dẫn: "Bí kíp luyện rồng" cho dân dev

Nếu bạn muốn tìm hiểu sâu hơn, có một hướng dẫn thực tế chi tiết về cách thiết lập đánh giá, hiểu các chỉ số, và tích hợp chúng vào quy trình phát triển. Tài liệu này đúng kiểu "cứu cánh" cho mấy anh em dev muốn cải thiện liên tục ứng dụng LLM của mình.

Kết luận: DeepEval - Công cụ không thể thiếu cho dân chơi LLM

Những chia sẻ của anh @svpino trên Twitter đã tạo một nền tảng vững chắc để hiểu về DeepEval. Bằng cách tận dụng thư viện mã nguồn mở này, bạn có thể đảm bảo ứng dụng LLM của mình không chỉ hoạt động tốt mà còn đáp ứng kỳ vọng của người dùng và tiêu chuẩn ngành. Trong bối cảnh AI ngày càng phát triển, mấy công cụ như DeepEval sẽ đóng vai trò cực kỳ quan trọng trong việc định hình tương lai của việc đánh giá và phát triển ứng dụng LLM.